Imágenes manipuladas con inteligencia artificial (IA) de la cantante Taylor Swift se difundieron de forma masiva en X la semana pasada. Nada anormal con esto. Sin embargo, el hecho de que fuesen montajes de ella posando desnuda, llevó a las redes sociales a bloquear las búsquedas relacionadas.

El viernes la red social X (antes twitter) se llenó de imágenes manipuladas de la cantante. En ellas, se habían utilizado herramientas de IA para que apareciera sin ropa. Esta práctica se conoce como deepfake y tiene la capacidad para hacer dudar de la autenticidad de las imágenes o videos en los que se aplica.

Esta difusión masiva se hizo sin el conocimiento ni el consentimiento de Taylor Swift. De hecho, puede rastrearse hasta un foro en la plataforma de mensajería Telegram. Allí, usuarios de una comunidad comparten imágenes manipuladas con herramientas como Microsoft Designer para desnudar a las mujeres, según lo informó 404 Media.

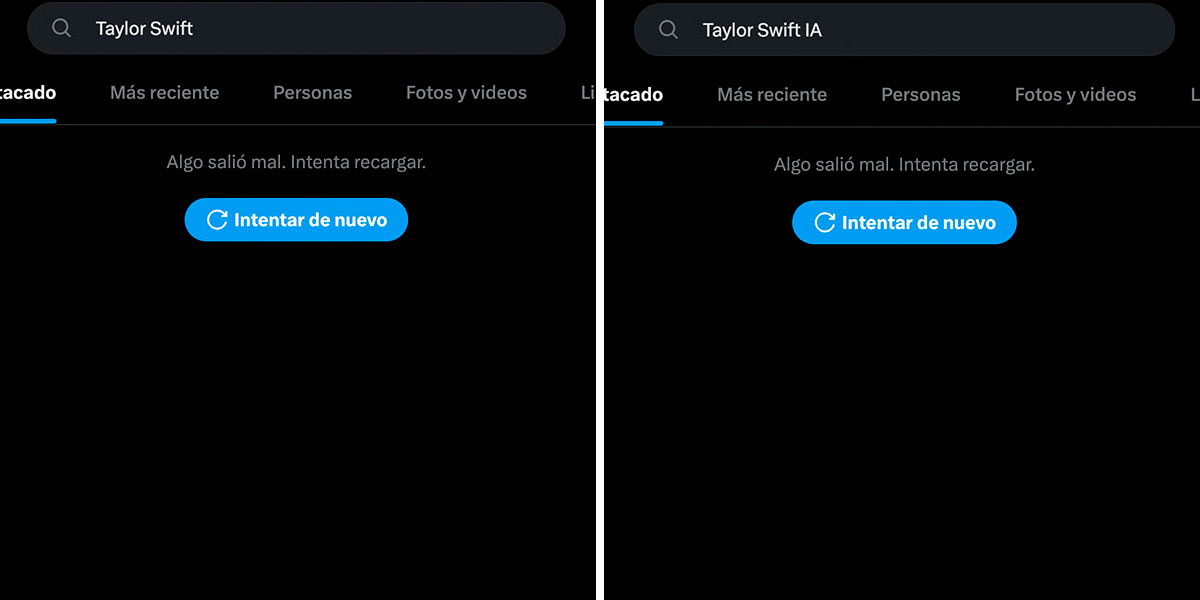

Todas las búsquedas de Taylor Switft están bloqueadas en las apps

Taylor Swift: acción y reacción

Luego de lo ocurrido, las búsquedas relacionadas con los deepfake de la cantante estadounidense se convirtieron en tendencia en X. Debido a esto, la plataforma confirmó que sus equipos estaban «eliminando activamente» todas las imágenes que se identificaban. Además, se estaban tomando acciones contras las cuentas que las habían publicado.

Antes de empezar a retirarlas, una de las publicaciones alcanzó los 45 millones de visualizaciones. Así mismo, obtuvo 24.000 republicaciones, e incluso registró cientos de miles de Me Gusta y marcadores, según apuntan en The Verge.

De forma adicional, X ha empezado a bloquear las búsquedas que utilizan palabras clave relacionadas con las imágenes manipuladas, como el propio nombre de la artista o ‘Taylor Swift AI’, que dan como resultado una notificación de error. Sin embargo, como señalan en The Verge, este bloqueo no es del todo efectivo, ya que puede sortearse al cambiar el orden de algunas palabras, por ejemplo, ‘Taylor IA Swift’.

Según el analista de redes sociales Matt Navarra, esta medida también la ha adoptado Meta para sus redes sociales Threads e Instagram.

Deepkafe pornográfico

El deepfake afecta principalmente a las mujeres. Según el estudio de la firma de soluciones de seguridad Home Security Heroes de 2023, la manipulación de contenidos audiovisuales protagonizado por mujeres supone el 77 % del contenido presente en webs. También, señalaron que en canales de YouTube, Vimeo y Dailymotion especializados, la cifra que asciende al 99 % de los casos en el deepfake pornográfico.

Las figuras públicas, además, tienen mayor probabilidad de ser víctimas de este tipo de manipulaciones, dada la visibilidad que tienen ante el público y la cantidad de imágenes disponibles de ellas. Por profesiones, son las cantantes (58%) y las actrices (33%) las que más engaños de este estilo protagonizan.

La manipulación de imágenes con herramientas de inteligencia artificial no es nueva. De hecho, el informe sitúa la evolución en 2014, con la aparición de las redes generativas antagónicas o adversiales (GAN), que se se pueden usar para generar imágenes sintéticas con gran realismo.

Los avances en esta tecnología en los últimos años han permitido ampliar sus capacidades, e incluso introducirla en servicios más asequibles y fáciles de usar. Esto ha extendido el uso entre usuarios que no necesitan tener un conocimiento especializado para usarlas.

Noticias Relacionadas

El periodismo independiente necesita del apoyo de sus lectores para continuar y garantizar que las noticias incómodas que no quieren que leas, sigan estando a tu alcance. ¡Hoy, con tu apoyo, seguiremos trabajando arduamente por un periodismo libre de censuras!

Apoya a El Nacional