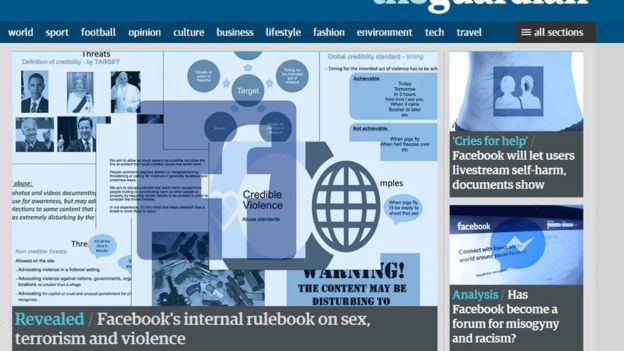

La forma en la que Facebook censura -o no- a sus usuarios acaba de ser revelada gracias a la publicación de varios documentos internos filtrados al diario británico The Guardian.

Según el periódico, los documentos muestran cuáles son los criterios empleados por la gigantesca red social para decidir si un contenido es demasiado violento, sexual, racista, incita al odio o hace apología del terrorismo.

The Guardian sostiene que los moderadores de Facebook están «sobrepasados» y tienen sólo algunos segundos para decidir si dejar o no los comentarios de sus usuarios.

Y según el especialista en temas de tecnología de la BBC, Rory Cellan-Jones, la filtración parece confirmar algo que Facebook siempre ha negado: que ya no es una simple red social, sino una publicación con criterios editoriales.

«Ha sido obvio desde hace algún tiempo que lidiar con el contenido controversial es uno de los retos más grandes que enfrenta Facebook», afirma Cellan-Jones.

La filtración

The Guardian afirma haber obtenido más de 100 manuales usados internamente por Facebook para entrenar a sus moderadores acerca de lo que se puede y no se puede publicar en la plataforma.

Por el momento, Facebook no ha negado ni confirmado la veracidad de los documentos.

Los criterios de Facebook fueron revelados por el periódico británico The Guardian

Pero los manuales cubren una amplia gama de temas sensibles, incluyendo discursos de odio, porno por venganza, autolesiones, suicidio, canibalismo y amenazas de violencia.

Y. como reconoce el mismo The Guardian, su publicación seguramente preocupará tanto a aquellos que exigen más acción por parte de la red social, como a los que están preocupados por el rol de facto de Facebook como «el mayor censor del mundo».

El periódico destaca, por ejemplo, que expresiones como «Qué alguien le dispare a Trump» deben ser borradas, pues en tanto jefe de Estado el presidente de EE UU está en una categoría protegida, pero que se puede conservar la expresión «Jódete y muere», pues esa no es considerada una amenaza creíble.

Y lo mismo aplica a expresiones como «Esa muchachita mejor que se quede tranquila antes de que papi le rompa la cara» o «espero que alguien te mate».

Excepciones

En uno de los documentos filtrados, Facebook admite que «la gente utiliza lenguaje violento para expresar su frustración en línea» y «se siente segura» haciéndolo en la plataforma, explica The Guardian.

«No todo el contenido desagradable o perturbador viola los estándares de la comunidad», dice también Facebook en uno de los documentos.

Según los documentos filtrados, las imágenes de abusos de animales pueden ser compartidas «para generar conciencia» | AFP

Así, como explica The Guardian, «los videos de muestres violentas, si bien deben ser marcados como ‘perturbadores’, no siempre tienen que ser borrados porque ayudan a crear conciencia sobre temas como problemas mentales».

«Algunas fotos de abuso físico y matoneo de menores, de carácter no sexual, tampoco tienen que ser borradas o requieren de alguna acción, a menos que haya un elemento sádico o de celebración», explica también la publicación.

Y, según los documentos filtrados, este tipo de imágenes tampoco se borran automáticamente «para que el niño pueda ser identificado y rescatado».

The Guardian también destaca que fotos de abusos de animales también pueden ser compartidas en Facebook «para generar conciencia» y solo las más extremas deben ser marcadas como «perturbadoras».

Y la red social también permite la transmisión en vivo de intentos de autolesionarse, porque «no quiere censurar o castigar a gente que está sufriendo», revelan los documentos.

Criterios confusos

Varios moderadores de Facebook, entrevistados por el el periódico, describieron las políticas utilizadas por la red para evaluar el contendido como «peculiares» e «inconsistentes».

Y, según ellos, el proceso para decidir si conservar o eliminar contenido sobre tópicos sexuales es particularmente «confuso».

Los criterios de Facebook también han ido cambiando con el tiempo | REUTERS

Los documentos muestran que Facebook cambió sus políticas sobre desnudez luego de la polémica que suscitó el año pasado cuando ordenó eliminar una icónica fotografía de la guerra de Vietnam porque la niña en la foto aparecía desnuda.

Ahora la plataforma permite «excepciones noticiosas», aunque eso no incluye imágenes de «desnudez infantil en el contexto del Holocausto», explica The Guardian.

Facebook también orienta a sus moderadores permitir el arte «manual» que muestre desnudos o actividad sexual, pero prohíbe sus representaciones digitales.

Vistazo alarmante

Según The Guardian, este vistazo al proceso de toma de decisiones de Facebook seguramente va a redoblar los llamados para que la red sea más cuidadosa con lo que publica o no, pero también para que sea más transparente con sus criterios.

«Trabajamos duro para hacer que Facebook sea tan seguro como sea posible, mientras posibilitamos la libertad de expresión», dijo, por su parte, en un comunicado, Monica Bickert, directora de políticas globales de Facebook.

Facebook anunció la contratación de 3.000 moderadores en mayo

«Esto requiere mucha reflexión en torno a preguntas muy detalladas y a menudo muy difíciles, y hacerlo bien es algo que nos tomamos muy en serio», agregó Bickert.

En mayo, luego de duras críticas de un comité parlamentario británico, Facebook anunció que había contratado a 3.000 personas para que revisaran el contenido.

La ONG británica Asociación Nacional para la Protección de la Crueldad con los Niños, dijo sin embargo, que el reporte sobre los criterios de Facebook publicado por The Guardian era «cuando menos alarmante».

«Necesitan hacer mucho más que contratar a 3.000 moderadores», dijo la ONG en un comunicado.

«Facebook, y otras redes sociales, deben ser reguladas de forma independiente y multadas si no logran mantener seguros a los niños», es su propuesta.

Por su parte, el Grupo de Derechos Abiertos, que trabaja temas de derechos digitales, dijo que el reporte demuestra la gran influencia que Facebook puede tener sobre sus 2.000 millones de usuarios.

«Las decisiones de Facebook sobre lo que es y no es aceptable tienen grandísimas implicaciones para la libertad de expresión», dijo la organización en un comunicado.

Muchos le piden a la red social más transparencia | REUTERS

Según la ONG, las filtraciones muestran lo complejo y difícil de esas decisiones.

Pero aunque «Facebook probablemente nunca va a lograr ser perfecto» al menos «deberían ser más transparentes sobre el proceso», sostiene.

Según Cellan-Jones, sin embargo, Facebook no publica todas sus reglas, porque si da demasiados detalles, eso puede ayudar a los que tratan de abusar el sistema.

El periodismo independiente necesita del apoyo de sus lectores para continuar y garantizar que las noticias incómodas que no quieren que leas, sigan estando a tu alcance. ¡Hoy, con tu apoyo, seguiremos trabajando arduamente por un periodismo libre de censuras!

Apoya a El Nacional